Здрастуйте, шановні читачі блогу . Хочу сьогодні знову повернутися до теми SEO оптимізації, якої останнім часом стосувався не так вже й часто, хоча на початковому етапі існування цього блогу присвячував просування левову частку часу. Ця Тема хвилює багатьох, бо загальні принципи СЕО прості і зрозумілі всім, а от деталі, які, власне, і вирішують успіх всієї компанії, відомі далеко не всім чи не всі звертають на них увагу.

Говорити я буду в основному про просуванні під Яндекс, хоча в світлі останніх подій (алгоритм пінгвін) оптимізація під Гугл теж перестала бути простою і зрозумілою всім. Відмінною рисою SEO 2012 можна назвати те, що зараз тупе нарощування посилальної маси не приносить бажаного результату і може спричинити негативне ставлення пошукових систем.

Також і переспам ключовими словами текстів статей або анкорів посилань може призводити до вильоту просуваються сторінок з Топа або істотного зниження їх ранжирування аж до пессимізації, фільтра або бана.

Seo вчора і сьогодні

Коли я починав знайомство з SEO в далекому 2009 році, все було зовсім по-іншому. Точніше вже тоді намітився перелом, але я використовував для навчання матеріали написані трохи раніше, а значить орієнтувався вже на застарілі ідеали. Поняття нудоти, відсоток входження ключових слів, ідеальний розмір тексту та інші речі вже канули в лету. Так само як і принцип — чим більше зовнішніх посилань, тим краще. Ні, звичайно ж, якийсь вплив все ж залишилося, але воно вже не превалює над іншими.

Раніше успішність просування на 4/5 визначалося саме зовнішньої оптимізацією, тобто купівлею або отриманням безкоштовних посилань. А решту 1/5 успіху визначали якість ваших текстів (внутрішня оптимізація), а також вік сайту і вік зворотних посилань. Зараз все докорінно змінилося, та й ви, напевно, самі про це чудово знають.

З’явився новий фактор ранжування (четвертий кит, на якому стоїть СЕО) — власні (поведінкові) фактори. Для різних сайтів існують, на думку пошуковиків (ми розглядаємо тільки Яндекс), різні моделі поведінки користувачів в пошуковій видачі і на самому ресурсі. І якщо ваш інтернет проект в цю модель не вкладається, то і місце в Топі йому буде не бачити.

Крім цього, три кита істотно змінили ступінь свого впливу — посилання здулися, а ось фактори часу і якості контенту суттєво підросли. Грубо кажучи, зараз всі ці чотири основних фактори ранжирування вносять рівний внесок у просування вашого сайту, що підтверджує озвучиваемое багатьма фахівцями неспроможність однобокого підходу до просування, який мав місце лише кілька років тому (посилання купили і вважайте, що ви вже в Топі).

Для некомерційних проектів зі значимістю зовнішніх посилань (особливо покупних) складається ще більш неоднозначна і гнітюча ситуація, яку я в повній мірі відчув на собі. Вплив покупних посилань знизилася настільки, що про це можна вже й забути (в плані просування по некомерційним СЧ і ВЧ запитам в Топ, а не в плані нарощування ТІЦ). Хоча можливі варіанти, про які, сподіваюся, ми ще поговоримо.

Технічний аудит сайту

За традицією хочу почати з внутрішньої оптимізації (технічний аудит, перелінковка, тексти), тим більше, що на даний момент цей фактор, з чотирьох озвучених вище, має найбільшу вагу, хоча і не абсолютний. Як я вже не раз говорив, існує маса нюансів, які можуть заважати просуванню і краще буде на ці граблі не наступати:

Тексти на сайті повинні бути унікальними. Як я писав у попередній статті про плагіат і перевірку унікальності текстів, домогтися цього буває не так просто як здається, бо існує таке поняття, як копіпаст або крадіжка контенту.

Але тут я акцентую увагу саме на те, що спочатку тексти потрібно не тирити (все одно отримаєте за це заслужений АГС рано чи пізно), а писати самим або замовляти у професійних копірайтерів (в першу чергу це стосується комерційних проектів, звичайно ж). Контент для сайту можна замовляти, наприклад, на біржах Етхт або Текстсейл, а для просування на Адвего.

Якщо ваш сайт не є статичним (складається з Html файлів вебсторінок в чистому вигляді), а є динамічним (тобто працює на якому-небудь движку), то слід у файлі robots.txt закрити все зайве (хоча б файли і папки самого движка) від індексації пошуковими системами.

Робити це потрібно для уникнення попадання сміття в індекс пошуковиків (дублів контенту у вигляді сторінок для друку, RSS стрічок, профілів користувачів сторінок внутрішнього пошуку або результатів сортування, дублів головної сторінки через додавання до неї index.php або index.html). Не ускладнюйте життя пошуку і він повернеться до вас обличчям.

Ми говоримо про Яндекс, але ось Гугл, наприклад, може ігнорувати ваші вказівки в файлику robots.txt, що сумно. Однак, він виконує вказівки з мета тега Robots, який можна прописати для кожної окремої сторінки вашого сайту. У різних CMS це можна зробити по-різному, але ось, наприклад, WordPress для цієї мети існує дуже зручний плагін All in One SEO Pack, який дозволить заборонити до індексації через мета тег Robots всякі повторювані лістинги, а також дозволяє додати враховується з недавніх пір і Яндексом мета тег Canonical до всіх сторінок сайту.

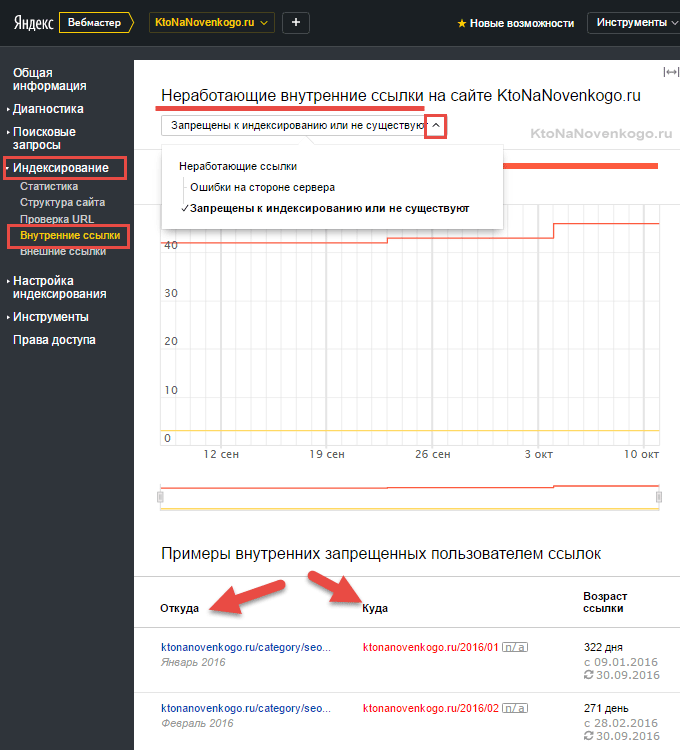

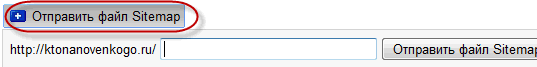

Додайте свого вихованця в панель Вебмастера від Яндекса (ну і в Гугл панель вебмастера теж). Будете отримувати інформацію про виникнення проблем на вашому ресурсі (наприклад, зараження сайту вірусами або черговому апдейте пошукової видачі Яндекса), а також отримаєте в руки ряд додаткових інструментів, про яких я досить докладно розповідав у статтях за наведеними трохи вище посиланнями. Наприклад, зможете застовпити авторство своїх текстів, хоча це поки і не враховується безпосередньо пошуком.

Там же через ЯВ можна відстежити деякі помилки вашого сайту, наприклад, сторінки не мають заголовка Title або ж мають однакові Тайтл, що не бажано. Можна буде знайти биті посилання на ваш ресурс, а прямим переглядом всіх проіндексованих Яндексом сторінок знайти серед них сміттєві або дубльовані.

По можливості потрібно зробити Html і CSS код вашого ресурсу валідним (відповідним загальновизнаним правилам). Якщо стосовно мови стильової розмітки CSS з питання валідації проблем не виникає (можна скористатися російською валідатором), то по відношенню до Html-все не так однозначно, бо стандарт Html 4.01 за версією W3C є зараз останнім з офіційно прийнятих стандартів, але вже у всю використовують деякі елементи Html 5, які підтримують браузери, але валідатор буде видавати з цього приводу помилки.

Тому не треба прагнути до абсолютно валидному Html коду, а використовувати, наприклад, російська валідатор для пошуку таких помилок, як не винесені в окремий файл css і джава скрипт коди. Останнє допоможе зробити код вашої веб-сторінки найбільш інформативним, бо в ньому буде набагато більше корисного тексту, ніж допоміжних елементів оформлення у вигляді тегів, CSS правил і Джаваскрипт коду.

Крім цього винос CSS і Джаваскрипта в окремі файли (а потім і об’єднання цих файлів) допоможе збільшити швидкість завантаження вашого сайту.

Закривання зовнішніх і внутрішніх посилань з допомогою Nofollow або noindex не принесе вам особливих дивідендів, бо вага (pagerank) зі сторінки через них все одно йде (хоч одержувач і не одержує), а значить посилання на інші сторінки цього ваги не доотримають. Уникнути такої неприємної ситуації можна або взагалі не ставлячи ці посилання (що не доцільно в плані, наприклад, юзабіліті і ПФ), або завантажувати їх на вебсторінку за допомогою технології Ajax (читайте тут детальніше).

Вважається, що пошуковики (у всякому разі Яндекс) поки такі лінки не враховують. Наприклад, Сергій Сосновський близько року тому провів експеримент на своєму блозі і приховав весь свій сайдбар за допомогою Аякса від пошуковиків. Попередньо він списався з Платоном Щукіним і переконався, що це дійство не буде вважатися клоакингом. Технічну частину цього неподобства реалізував, напевно, всім вам відомий Димокс (кнопки соціальних мереж share42 належать його перу).

Зробити це не так складно як здається і шановний Димокс досить докладно описав це на своєму блозі. Інша справа, що Сергій Сосновський не відчув вихлопу від приховування сайдбара в Аяксі.

Швидше за все це пов’язано з тим, що пошукові системи розрізняють наскрізні посилання з сайдбара і меню (або будь-яких інших наскрізних блоків), практично не враховуючи їх при розподілі статвеса. Однак, не наскрізні блоки і посилання можна буде з успіхом довантажувати з допомогою Аякса, закриваючи їх індексацію пошуком, але не зрозуміло, як довго це буде робочим варіантом.

Ну і останнім пунктом (але не останнім по значимості) хочу відзначити наявність осмислених Url-адрес сторінок — так званих ЧПУ (человекопонятных урлов). Це актуально, звичайно ж, тільки для проектів, побудованих на основі CMS, де в урли включаються різні програмні запити.

Це не лише спотворює адреси сторінок, але і в якійсь мірі спрощує злом сайту. Тому потурбуйтеся на самій ранній стадії створення проекту налаштуванням ЧПУ вашої CMS (читайте про ЧПУ в WordPress і SEF для Joomla). Якщо сайт вже давно і успішно існує без ЧПУ, то краще все залишити як є, бо краще — ворог хорошого.

Не все з вищеперерахованого я зробив на своєму блозі, та й, напевно, не все згадав, але ви можете самі подивитися пам’ятку, яку повинен виконати для себе будь вебмастер береться за просування свого або чужого проекту. Пунктів там дуже багато, але всі вони мають значення і впливають на успіх просування в тій чи іншій мірі.

Внутрішня оптимізація

Трохи вище я згадав, що вже не варто звертати серйозної уваги на частоту вживання ключових слів, на розміри текстів, виділення ключів стронгами і т. п. речі, бо вони вже не грають визначальної ролі. Це так, але пошуковики як і раніше не володіють інтелектом людини і їм треба чітко давати зрозуміти, про що саме ваша стаття і за якими пошуковими запитами ви плануєте просуватися і займати Топ видачі. Треба і від цього нікуди не дінешся.

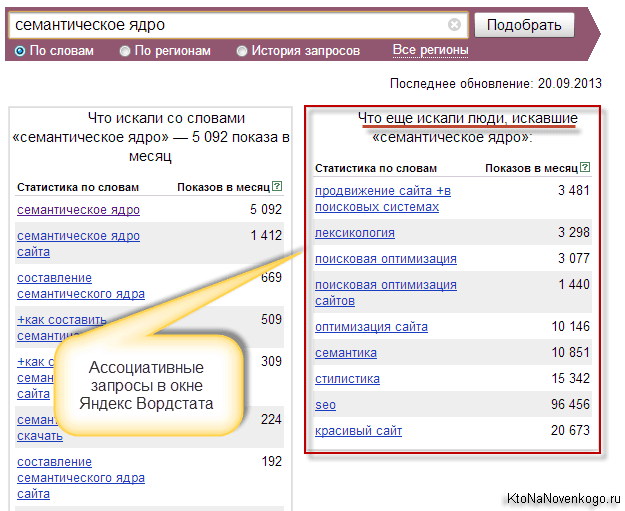

Спочатку потрібно буде скласти семантичне ядро (підібрати пошукові запити для всіх сторінок всього вашого сайту). Особисто я для цього некомерційного блогу складаю ядро безпосередньо перед написанням статті (дана публікація не оптимізована і не зможе залучати відчутний трафік з пошукачів, бо її завдання полягає не в цьому), але у випадку проектів комерційних це потрібно буде зробити відразу для всього ресурсу.

При просуванні під Яндекс краще всього дивитися частоту пошукових запитів в його власній статистиці — Яндекс Вордстаті. Більш докладно про роботу зі статистикою пошукових запитів Яндекса та інших пошукачів читайте за посиланням. Без семядра ви віддаєте успіх свого проекту на волю випадку і по теорії ймовірності швидше за все програєте і не досягнете тих висот відвідуваності, які дозволять здійснювати успішні продажі або заробляти грошики на некомерційному проекті.

Крім просуває сторінки, на вашому ресурсі повинні бути ще сторінки з тієї ж самої спрямованістю, оскільки це допоможе в подальшому легше увійти в Топ. Приклад. Нещодавно я написав статтю про QR-коди, попередньо підібравши семантичне ядро і слідуючи описаним трохи нижче правилами. Але шансів у неї вийти в Топ вкрай мало, бо інших публікацій на подібну тему у мене на блозі не є.

Ну, а в силу того, що покупка посилань (я фанат вічних в ГГЛ і статей в Міралінкс) для некомерційних запитів зараз не рулить, і допомогти їй я нічим не зможу. Навіть внутрішня перелінковка не дасть результату, знову ж таки в силу відсутності сторінок з відповідним контентом.

Чи То справа статті по тематиці SEO — тут мені дуже хороший заділ вдалося створити і можна намагатися вже щось отримувати з пошуку з цієї тематики (наприклад, стаття про розкрутку сайту займає хороші позиції). Основний внесок у це, на мою думку, внесли саме внутрішні посилання з релевантних запиту сторінок. Не було б релевантних сторінок, не було б і можливості внутрішньої оптимізації з допомогою перелінковки.

Тепер по ключам, тобто ключовим словами. Як я вже сказав — без них нікуди, тому потрібно обов’язково використати їх у наступних елементах оформлення веб-сторінки, але при цьому знати міру і дотримуватися основне правило — природність. Є така наука — статистика, яка при роботі з великими масивами даних здатна чітко визначити відхилення частоти вживання ваших ключових слів в тексті від природного.

Навіть якщо в окремих сайтів (наприклад, мого блогу) такий перекіс має місце бути, то це зовсім не говорить, що так і потрібно робити. Присовокупится ще один який-небудь негативний фактор і буде просідання. Але давайте все ж поговоримо про те, куди треба красиво і лаконічно вставляти ключі:

- Заголовки сторінок Title (архіважливо) і опису Description (бажано, але не обов’язково)

- Заголовки H1, H2 і нижче

- Стронги і інші теги акцентування, але, звичайно ж, не так, як це робили раніше. Тобто не треба в стронги заганяти всі прямі входження ключів в тексті. Достатньо просто робити виділення для зручності користувачів і захоплювати ними іноді (як би випадково) ключові слова.

- Використовувати ключові слова потрібно і в самому тексті, але при цьому не перевищуючи частоту появи в 2%, а для великих текстів і того менше. Особисто я вважаю, що 1% цілком буде достатньо.

- На довжину текстів будь-яких серйозних обмежень немає, але якщо він буде менше 1500 — 2000 знаків, то існує можливість втрати його унікальності на тлі важкого обваження (меню, колонок та інших елементів, які є наскрізними і тому однаковими для всіх сторінок)

Удачі вам! До зустрічей на сторінках блогу