Здрастуйте, шановні читачі блогу . У минулій статті ми розглянули в загальних рисах покроковий план просування комерційних сайтів.

Будемо вважати, що ви вже прочитали і для вашого сайту були чітко визначені цілі та завдання, які вирішуються, виявлена цільова аудиторія, призначені ключові показники ефективності вашого інтернет-проекту і обрані канали для його просування.

Якщо одним з таких каналів було обрано SEO, то вам має сенс ознайомитися з цією публікацією, в якій ми спробуємо залізти в шкуру Сео-фахівця, якому ви хочете просунути ваш сайт. Ну і постараємося зрозуміти, які методи Сео просування варто використовувати, а так само розкриємо деякі завіси в роботі пошукових систем.

Чи Легко зараз бути Сео-шником

Зараз працювати в області SEO може далеко не кожна людина. Тут потрібен особливий склад характеру, бо існує цілий ряд проблем, з якими постійно стикається подібний фахівець:

Під який пошуковик просуватися?

Крім всіх описаних вище труднощів, Сео-шники змушені при просуванні сайтів намагатися «прислужитися» принаймні двом господарям — Яндексу і Гуглу. А якщо брати в розрахунок і пошук Mail.ru, то трьом.

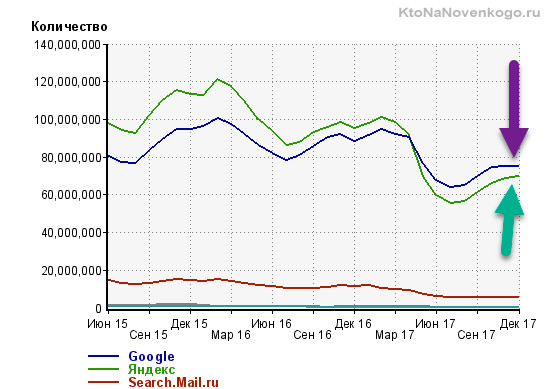

Якщо вірити показанням лічильника Ливинтернет, то в рунеті (доменній зоні RU) зараз спостерігається приблизний паритет між Яндексом і Гуглом, а частка інших пошукових систем зникаюче мала на їх фоні (хіба що тільки за виключення Майла, але там особлива аудиторія, яка в основному складається з користувачів інших сервісів цієї корпорації).

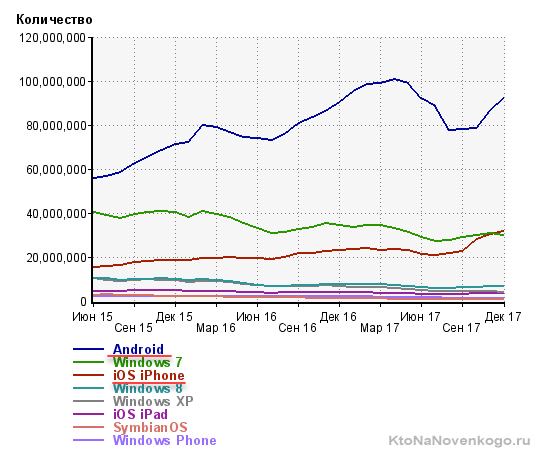

Гул здорово підросла за останні роки, бо раніше перевага у Яндекса був чи не удвічі. Секрет криється в тому, що зараз йде тенденція до збільшення частки мобільного трафіку (відвідувачів, які заходять на сайти зі смартфонів і планшетів), а у Google тут величезну перевагу у вигляді власної мобільної платформи Android і встановленим там за замовчуванням пошуком. Хід конем, що називається.

Як видно з даних того ж Лайвинтернета, трафік з Андроїда складає більше третини від усього трафіку рунета. Ви тільки вдумайтеся? А якщо брати в розрахунок і інші мобільні платформи, то число людей, що заходять в мережу з мобільника вже перевищило число тих, хто заходить з ПК або ноутбука. Далі буде ще більший відхід у мобільність і це знову ж додає нових проблем сеошників і маркетолагам, бо істотно змінюється поведінка користувачів на сайті.

По-любому, від просування в Google (а вже тим більше в Яндексі, бо саме там сидить велика частина цільової аудиторії по багатьом комерційним тематик) ніхто просто так відмовитися не може, і практично всі комерційні сайти зараз просуваються під обидва цих пошуковика.

Ну, а якщо сайт буде орієнтований на буржунет, то там вже у Гугла взагалі практично немає гідних конкурентів. На світовому рівні вони навіть не порівняти. Людські, фінансові та апаратні ресурси відрізняються на порядок. А це впливає на те, як працюють алгоритми Google, і на те, як швидко він працює в цілому.

Крім цього, якщо знову повернутися до рунету, у Яндекса і Гугла істотно відрізняються аудиторії. Може цілком виявитися так, що вся ваша цільова аудиторія користується тільки Гуглом (або тільки Яндексом).

Скажімо так, в Яндексі більше чайників. І це зовсім не погано, бо з них виходять відмінні покупці, але якщо ваш товар або послуга орієнтована на трохи більш просунутих користувачів, то Google може стати для вас основним джерелом трафіку. Якісь глобальні дослідження на цей рахунок ви навряд чи знайдете в паблике, але я думаю, що почавши розвивати і просувати сайт, ви швидко зрозумієте, яка пошукова машина для вас є пріоритетною.

Якщо говорити про пошук Майл.ру, то його частка в рунеті складає десь близько п’яти відсотків і вона обумовлена насамперед тим, що всі сервіси Майла збирають величезну аудиторію в рунеті (навіть більшу, ніж всі сервіси Яндекса). При цьому у них періодично змінюється пошуковий движок. Вони постійно торгуються з Яндексом і Google про надання їм кращих умов, а коли домовитися не вдається, то тимчасово використовують свій власний движок gogo.ru.

Біле, сіре і чорне SEO

Отже, SEO спеціаліст повинен буде всіма правдами і неправдами змусити згадані вище пошукові системи звернути увагу на просувний їм сайт (хоча б у плані його повної індексації) і якимось хитрим і незрозумілим способом змусити їх полюбити. І це все при тому, що пошукачі в своїх ліцензіях чітко говорять, що при ранжуванні і визначенні релевантності документів ними будуть враховуватися виключно інтереси користувачів пошуку, а аж ніяк не власників ресурсів.

Значить доведеться «хитрувати» і часто йти на свідоме порушення всіх цих ліцензій. Залежно від ступеня хитрощів і глибини порушень правил пошукових систем SEO просування можна розділити на три групи:

Проте, ці методи використовуються, та у видачі Яндекса і Гугла можна за деякими запитам спостерігати, наприклад, засилля дорвеїв, а в індексі пошуку все так само є величезна кількість ГС (дивіться незрозумілі вам терміни у статті про те, як почати розуміти Сеошників).

Перерахую приклади чорного SEO без вдавания в конкретику, бо ніколи цим не займався і займатися не має наміру:

Що потрібно знати про роботу пошукових систем

Однак для того, щоб застосовувати озвучені способи оптимізації, сеошник повинен насамперед розуміти хоча б загальні принципи роботи пошукових машин. І чим більш ризикованим SEO він збирається займатися, тим більш глибокими і детальними повинні бути його пізнання.

Індексація сайтів

Роботу починає пошуковий робот (бот), який представляє з себе звичайний комп’ютер (сервер) з відповідним. Він обходить сторінки з потенційним наявністю якісного і унікального контенту, знаходить вебсторінку, визначає її вміст (об’єм, якість), і якщо вона йому сподобається, то він передає її на наступний рівень, який можна визначити, як пошуковик.

У силу апаратних обмежень роботи не снують в інтернеті як заведені, а керуються певними принципами. По-перше, вони ходять на сторінки, на яких проставлено багато посилань зі сторінок, які вже є в індексному базі. По-друге, частота повторного відвідування не завжди висока і розраховується індивідуально.

У Яндекса можна виділити два типи роботів:

Пошук потрібної інформації в індексі

Пошуковик представляє з себе знову ж звичайний сервер (що таке сервер), але вже з іншим програмним забезпеченням. У його завдання входить обхід знайдених ботом сторінок, завантаження їх вмісту і подальша його обробка (створення індексу).

Всі позначені пошуковим роботом сторінки викачуються (у вигляді вихідних Html кодів), з них витягується контент (текст укладений в Html коді, який повинен бачити відвідувач) і проводиться його первинний розбір і аналіз. Текст веб-сторінки записується в окремий файл (умовно) і туди ж записуються всі посилання, знайдені на сторінці (вони потім відправляються пошуковому роботу, щоб він туди сходив теж).

З отриманого тексту видаляються всі стоп-слова (сполучники, прийменники) і розділові знаки. Отриманий в результаті набір слів розбивають на так звані пасажі. По суті, це пропозиції, але з деякими допущеннями. Пасажі, як і пропозиції, об’єднуються смисловою закінченістю, але оперувати саме пропозиціями, при машинному аналізі російського тексту, практично не можливо (в силу його «великости і могучести»).

Тобто аналіз ведеться не за фізичною (спочатку наявними в тексті) пропозицій, а по новоствореним (машинним), які й назвали пасажами. Ну, а ці самі елементи вже складаються в індексну базу і кожного пасажу присвоюється своя вага, що характеризує його значимість усередині цього тексту. Від чого може залежати вагу? Наприклад, від того, наскільки цікавий пасаж даного тексту, скільки разів він у ньому повторюється і де всередині тексту він розташований.

В результаті формується база даних (пошуковий індекс), в якій кожна проіндексована веб-сторінка представлена набором пасажів з віддаленими шумовими словами (безглуздими, сполучними паразитними, повтореннями). Саме по цій базі (індексу) ведеться пошук.

Коли вам потрібно буде увігнати в індекс нові сторінки, що з’явилися на сайті, то кращим варіантом будуть сервіси по залученню быстробота (індексування) пошукових систем. Серед них можна виділити два схожих — IndexGator і GetBot. Коштує це справа зовсім не дорого, а ефект досить стабільний.

Визначення релевантності та ранжування результатів

На самому верхньому (до користувачів пошукових систем) знаходиться пошуковий сервіс, який приймає запити від користувачів, і на підставі розрахунку релевантності та застосування факторів ранжирування вибирає (з створеного на попередньому етапі пошукачем зворотного індексу) потрібні вебстранички, які потім будуть показані користувачеві в якості видачі (серпа).

Спрощено це можна представити так, що відвідувач Яндекса задає своє питання і пошукова система починає шукати у своїй індексного базі сторінки містять пасажі, які максимально відповідають цьому запиту. Отриманий список релевантних сторінок тепер потрібно буде ранжувати (розставити пріоритети), тобто визначити послідовність розташування цих вебсторінок у видачі.

Перший принцип, який почав використовуватися вже дуже давно, називається індексом цитування. В його базової версії він враховував кількість згадок даної сторінки (число провідних на неї посилань). Про цю систему я досить докладно писав у статті про те, що таке Тіц і Віц сайту в Яндексі. Недолік такого підходу полягає в тому, що враховується лише загальна кількість посилань, але не їхню якість.

Тому далі був придуманий зважений індекс цитування, який враховує авторитет і якість сайтів, що посилаються. З’являються так звані ваги (статичні), які передаються по посиланнях. У Google це індекс називається Пейдж Ранком, тулбарное значення якого раніше можна було дізнатися для будь-якої сторінки будь-якого сайту (зараз це діло прикрили).

Зважений індекс цитування можна описати, як коефіцієнт ймовірності попадання відвідувача на дану вебсторінку з будь-якої іншої сторінки мережі інтернет. Іншими словами, чим більше на цю сторінку посилань і чим більше серед посилаються ресурсів буде авторитетних, тим імовірніше буде відвідання даної сторінки і тим вищою буде її вагу. Він розраховується за допомогою формули в кілька ітерацій. Формула ця періодично змінюється і допрацьовується.

Раніше ми могли спостерігати тулбарное значення ПейджРанка, яке оновлювалося раз у кілька місяців і було побудовано на основі логарифмічної шкали, коли реальна різниця між вагою сторінки з ПР=1 і ПР=7 могла бути тысячекратной або навіть більше. Подробиці читайте у згаданій трохи вище статті.

Також слід розуміти, що те або інше значення ПейдРанка для вашої сторінки на її позицію у видачі по тому чи іншому пошуковому запиту прямого впливу надавати не буде. Але в той же час алгоритм, закладений у розрахунку ПР, використовується при ранжируванні сторінок, а значить його потрібно знати і розуміти, щоб в подальшому використовувати для своєї користі.

Облік трансляції посилальних ваг при ранжируванні

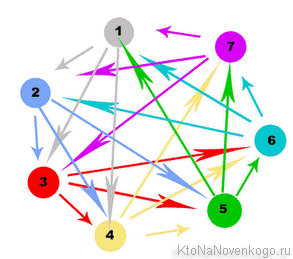

У схемі ПейджРанка (зваженого індексу цитування) є таке поняття, як передається за посиланням вагу.

Статична вага передається по посиланнях

Передача ваги є не зовсім правильним терміном, бо вага не передається, а транслюється, тобто донор (читайте статтю про SEO терміни) нічого не втрачає при установці посилання, але при цьому акцептор отримує за нею певний статичний вагу. Під терміном статичний слід розуміти те, що ця вага не залежить від того, що використовується в якості анкора посилання.

Скільки ваги може передати та чи інша веб-сторінка в інтернеті можуть знати тільки алгоритми пошуковиків. Але достеменно відомо, що цей самий вага буде порівну поділено між усіма сторінками-акцепторами, на який будуть вести посилання з цього донора. Виходячи з цього принципу можна зробити багато висновків з зовнішньої і внутрішньої перелінковки сайту.

Загальний висновок за принципом трансляції ваг — для того, щоб прокачати яку-небудь свою сторінку, потрібно отримувати на неї посилання, бажано з авторитетних сторінок. А як дізнатися, чи високий авторитет тієї або іншої сторінки в інтернеті? Правильно, потрібно подивитися на значення ПейджРанка для неї.

У Яндекса теж є аналог пейджранка, який розраховується для всіх сторінок (ВІЦ), але впізнати його значення зараз не представляється можливим. Також у нашого пошукача є в арсеналі ще й тематичний індекс цитування Тіц, при розрахунку якого насамперед враховується тематика посилаються ресурсів.

Вимірюється він для всього сайту в цілому. Для тематичних посилань (оцінюється тематика за змістом тексту) застосовується підвищувальний коефіцієнт, порівняно з околотематическими і нетематичними, для яких може застосовуватися серйозна сбавка переданого ваги. Тому для нарощування Тіц важливі посилання не просто з авторитетних ресурсів, а бажано, щоб вони були близькою або збігається тематики з вашим сайтом. Безпосередньо на ранжування він не впливає, але ті ж принципи використовуються для побудови сайтів у видачі.

Динамічний вагу, залежить від тексту посилання (анкора)

До цього моменту ми говорили лише про статичні ваги. Однак, при розрахунку трансляції ваги для будь-посилання, пошукові машини використовують два типи ваг. Перший — статичний, про який ми вже поговорили і який розраховується без урахування тексту посилання (її анкора). Другий — динамічний (анкорный), який розраховується на підставі декількох параметрів:

Чим більш релевантні ці три складові, тим більш високий анкорный вага буде транслювати посилання. Якщо у посилання немає анкора (безанкорная), то динамічний вага, рухаючись по ній, не розраховується зовсім. Статична вага передається завжди, якщо тільки сайт донор не знаходиться під фільтр пошукових систем за продаж беклінків.

Звідси можна зробити дуже важливий висновок — будь-яке посилання, проставлена на ваш сайт, може бути цінною для вас двома своїми вагами. По-перше, ми нагінкою статична вага своєю веб-сторінки, що є добре. Але якщо ще грамотно використовувати анкор, то значимість цієї ж посилання може бути збільшена в декілька разів.

Що потрібно зробити, щоб отримати високий анкорный вага? Спробуємо розписати по пунктах:

Про використання в анкор прямих і розбавлених входжень ключових слів ви можете почитати за наведеною трохи вище посиланням.

Удачі вам! До зустрічей на сторінках блогу