Здрастуйте, шановні читачі блогу . Перебуваючи на початковому етапі пізнання пошукової оптимізації, чимало маркетологів і майбутні SEO-фахівці стикаються зі шквалом різнорідної інформації, яку спочатку важко упорядкувати і структурувати.

Яким аспектам SEO варто приділити увагу в першу чергу? З чого почати оптимізацію сайту? Як провести первинний технічний аудит і обробити отриману інформацію? Відповіді на ці та інші питання ви знайдете в даній статті.

1. Інструкції щодо індексації

Настройка інструкції для пошукових роботів — чи не перше, з чим доводиться розбиратися кожному початківцю фахівця, і однозначно перше, в чому допускається основна маса фатальних помилок, що перешкоджають пошуковому просуванню сайту.

У числі найбільш поширених промахів можна назвати наступні:

Визначити, які інструкції виставлені на сторінках всередині вашого сайту, і чи немає якихось проблем, пов’язаних з неправильним зазначенням директив robots.txt, Meta Robots або X-Robots-Tag, можна за допомогою краулера. Ми будемо використовувати в якості інструменту для проведення SEO-аудиту Netpeak Spider.

Отже, для аналізу пошукових директив потрібно зробити наступне:

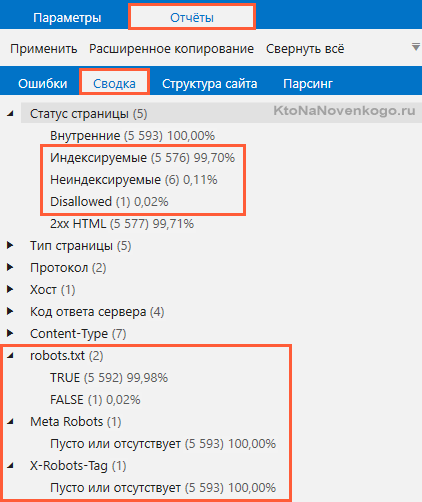

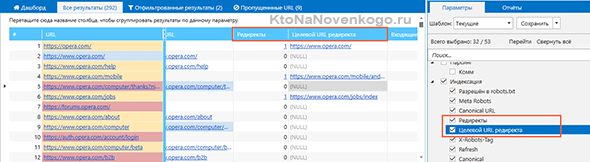

За підсумком сканування ви зможете отримати деталізовану інформацію кількома шляхами:

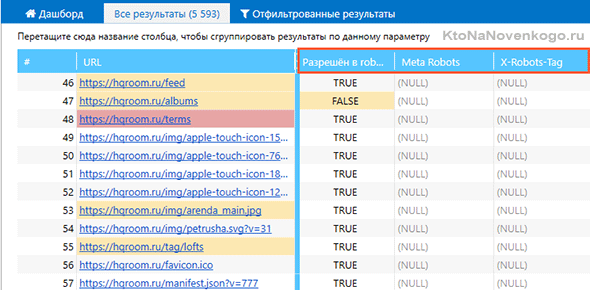

За підсумком сканування перед вами з’явиться таблиця з повним списком просканованих сторінок. У стовпці «Дозволений в robots.txt» ви побачите, не закритий кожен окремий URL від індексації, а в стовпцях «Meta Robots» і «X-Robots-Tag» будуть вказані застосовані до даного URL директиви.

Вибравши зацікавив вас ознака, якому відповідають ті чи інші сторінки, ви отфильтруете результати сканування, зосередившись виключно на тих URL, для яких robots.txt прописаний Disallow, або, приміром, на яких виставлено nofollow, noindex за допомогою Meta Robots або X-Robots-Tag.

На підставі результатів сканування програма визначає кілька десятків типів помилок, в тому числі — помилки (попередження), пов’язані з інструкціями для індексації.

На вкладці «Дашборд» по сусідству з таблицею результатів сканування інформація про індексованих і неиндексируемых сторінках сайту буде представлена у вигляді кругової діаграми. Там же можна буде знайти діаграми, що наочно демонструє причини неиндексируемости.

Кожен із сегментів діаграми кликабелен і діє за аналогією з фільтрацією, яка була описана вище.

2. Метатеги Title і Description

Оптимізація мета-тегів Title і Description — один з найважливіших етапів пошукової оптимізації сайту. По-перше, їх вміст ретельно аналізується пошуковими роботами для складання загального уявлення про вміст сторінки. По-друге, саме вони формують фрагментом сторінки в пошуковій видачі.

У розрізі SEO-аудиту сайту необхідно проаналізувати:

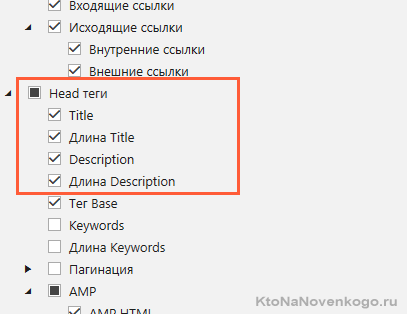

Щоб з’ясувати, як йде ситуація з даними метатегами в рамках вашого сайту, обов’язково відзначте на бічній панелі параметри «Title», «довжина Title», «Description» і «довжина Description».

До речі, якщо вам потрібно, щоб Title і Description були строго визначеної довжини, ви можете задати діапазон допустимих значень у розділі «Налаштування» → «Обмеження».

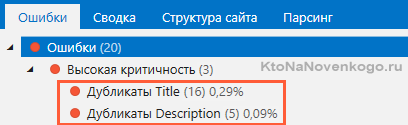

В процесі сканування програма визначить довжину кожного з метатегів, а на вкладці з помилками вкаже всі наявні проблеми Title і Description.

3. XML карта сайту

Перш ніж приступити до перевірки карти сайту, відповісти собі на два питання:

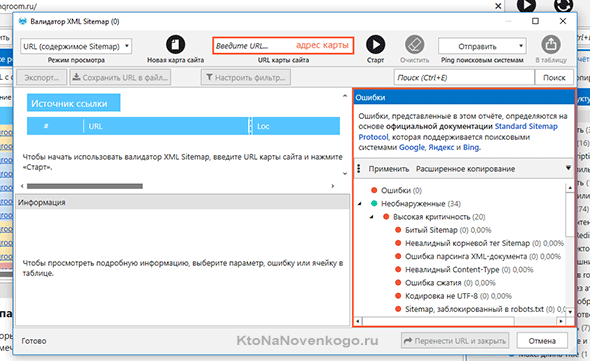

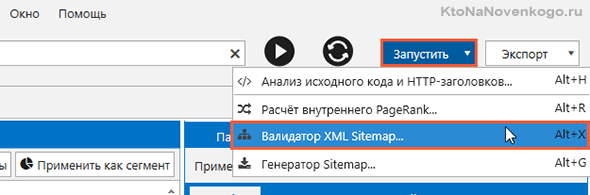

Якщо відповідь на обидва питання «так», фахівця, який здійснює аудит, залишається тільки одне: проаналізувати карту на наявність різного роду помилок. Найкраще робити це за допомогою вбудованого в Netpeak Spider інструменту «Валідатор XML Sitemap». Для запуску перевірки вам потрібно:

*при кліці по картинці вона відкриється в повний розмір у новому вікні

4. Час відповіді сервера

Чим швидше ваш сайт працює, тим краще. Це стосується швидкості відповіді сервера, який повинен максимально швидко відгукнутися на запит, відправлений вашим браузером, а також швидкості завантаження самого контенту.

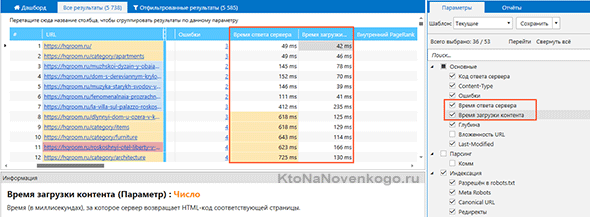

Для аналізу обох показників ми скористаємося краулером. Процедура сканування проводиться за аналогією з тією, що ми описували вище: головне — не забути зазначити параметри «Час відповіді сервера» і «Час завантаження контенту» перед стартом аналізу.

*при кліці по картинці вона відкриється в повний розмір у новому вікні

Після закінчення сканування занадто повільні сторінки будуть відзначені як сторінки з помилкою середньої критичності «Великий час відповіді сервера».

5. Дублікати

Повне або часткове дублювання контенту всередині сайту, нехай навіть ненавмисне, може суттєво ускладнити шлях вашого сайту до вершин органічної пошукової видачі. Пошукові системи вкрай негативно реагують на дублі, так що в рамках SEO-аудиту слід звернути увагу на всі основні види дублів всередині свого сайту для їх подальшого усунення.

Скануючи сайт в Netpeak Spider, ви зможете виявити повні дублікати сторінки, а також дублікати метатегів Title і Description (ми вже говорили про них у параграфі 2), заголовків H1 і текстового вмісту.

6. Контент

Грамотно оптимізоване вміст сторінки повинно включати в себе:

Якщо у вас є чітке розуміння того, в яких межах може змінюватись вага зображень, розмір H1 і обсяг тексту, їх можна задати вручну в розділі «Налаштування» → «Обмеження».

Щоб перевірити кожний із зазначених вище аспектів, слід:

Якщо ви хочете додатково перевірити сайт (розділ сайту, список сторінок) на предмет наявності підзаголовків H2 і H3, відмітьте відповідні параметри у пункті «Заголовки H1-H6».

Списки URL, що містять одну (або більше) з помилок вище, можна відфільтрувати і вивантажити у вигляді окремого звіту.

7. Биті посилання

Існує безліч неоднозначних факторів пошукової оптимізації, щодо яких в експертному середовищі немає однозначної думки. Однак биті посилання (посилання, що віддають 404 код відповіді сервера) точно не відносяться до їх числа: усі досвідчені фахівці в один голос твердять про їх вкрай згубний на оптимізацію сайту.

Пошук битих посилань — процедура, яку вам належить виконувати на регулярній основі, а не тільки в рамках глобального первинного SEO-аудиту.

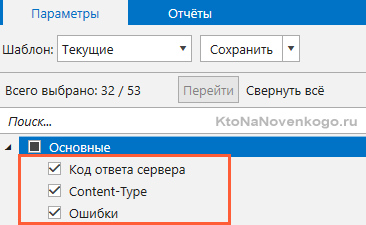

Для аналізу сайту на предмет пошуку битих посилань достатньо буде активувати всього три параметра: «Код відповіді сервера», «Content-Type», «Помилки».

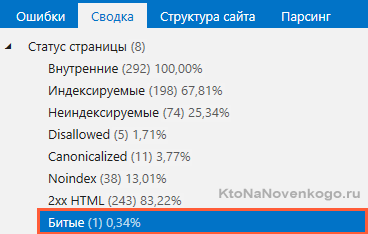

За підсумком сканування ви зможете знайти всі сторінки, що віддають 404 помилку, в основній таблиці з результатами сканування (навпроти них буде зазначено відповідний код відповіді сервера), на панелі «Зведення», а також у списку сторінок, відфільтрованих по помилок «Биті посилання» і «Биті зображення».

8. Редиректи

Встановлення перенаправлень, або редиректів, — обов’язковий етап оптимізації будь-якого сайту. Редиректи допомагають боротися з дублікатами і направляти користувачів на потрібні сторінки в разі переходу на вже неіснуючі URL.

Важливо пам’ятати про те, що виставлений на постійній основі редирект повинен віддавати виключно 301 (не 302) код відповіді, а також не повинен вести на сторінку з подальшою переадресацією. Також не забувайте, що для успішної індексації цільової сторінки пошуковими роботами вона не повинна бути закрита за допомогою robots.txt, Meta Robots або X-Robots-Tag.

Таким чином, у числі основних проблем, пов’язаних з переадресацією, можна назвати наступні:

В процесі проведення технічного аудиту ви зможете виявити на вашому сайті всі вищезазначені проблеми, а також проконтролювати правильність вказівки кінцевих URL для переадресації.

*при кліці по картинці вона відкриється в повний розмір у новому вікні

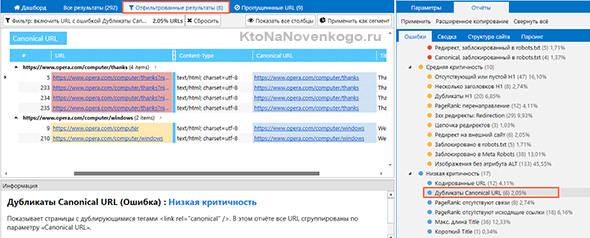

9. Атрибут rel=canonical

Не виключено, що на підході до дев’ятим пунктом вам на мить могло здатися, що все найважливіше вже залишилося позаду. Однак до тих пір, поки в чекліст SEO-аудиту не включений аналіз атрибута Canonical, його не можна вважати повноцінним. Які ж проблеми можуть бути пов’язані з неправильною налаштуванням Canonical?

Також не варто забувати про ймовірність того, що якісь із атрибутів були виставлені помилково, а тому не дозволяють як слід індексуватися важливим сторінок вашого сайту. Щоб проконтролювати цей аспект оптимізації, ми рекомендуємо скористатися фільтрацією по таких помилок (попередженням низькій критичності) Netpeak Spider, як «Неканонічні сторінки» і «Дублікати Canonical URL».

Перша показує неканонічні сторінки, у яких URL в теге

вказує на іншу сторінку, друга показує сторінки з дублюючими тегами (при використанні цього фільтра все URL будуть згруповані по параметру «Canonical URL»).

*при кліці по картинці вона відкриється в повний розмір у новому вікні

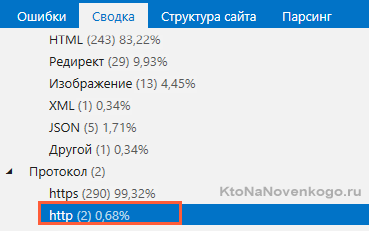

10. Змішаний контент

Якщо раніше ви здійснили спробу «переїзду» захищений протокол HTTPS, але не налаштували сайт необхідним чином, ви зіткнетеся з таким поняттям як «змішаний контент». Воно означає, що на сайті одночасно є сторінки з безпечним і небезпечним протоколом. Щоб перевірити, чи відноситься це і до вашого сайту, запустіть сканування з параметрами за замовчуванням.

Список сторінок, протокол яких не змінився після переїзду на HTTPS, можна буде знайти на бічній панелі на вкладці «Зведення».

Також вони будуть підсвічені як сторінки з помилкою (низька критичність) «Не HTTPS-протокол».

Коротко про головне

Щоб провести базовий технічний SEO-аудит сайту перед початком роботи над новим проектом, включіть в нього перевірку кількох основних пунктів:

Для аналізу вам знадобиться краулер, в якості якого ми використовували Netpeak Spider. який визначить всі ключові проблеми сайту для їх подальшого усунення.

P. S. Для читачів блогу діє спеціальна знижка на купівлю ліцензій Netpeak Spider – 10%. Щоб її використовувати, на етапі оплати введіть промокод 8018e2e0

Удачі вам! До зустрічей на сторінках блогу