Здрастуйте, шановні читачі блогу . Займаючись SEO або, інакше кажучи, пошуковою оптимізацією, як на професійному рівні (просуваючи за гроші комерційні проекти), так і на аматорському рівні (самостійна розкрутка сайту описана мною тут), ви обов’язково зіткнетеся з тим, що необхідно знати принципи роботи пошукових систем в Росії і в інтернеті в цілому для того, щоб успішно оптимізувати під них свій чи чужий сайт.

Ворога, як кажуть, треба знати в обличчя, хоча, звичайно ж, вони (для рунета це Яндекс і лідер світового пошуку Google.ru, про якого ми говорили тут) для нас зовсім не вороги, а швидше партнери, бо їх частка трафіку є в більшості випадків превалює і основний. Є, звичайно, винятки, але вони лише підтверджують це правило.

Що таке сніппет і принципи роботи пошукових систем

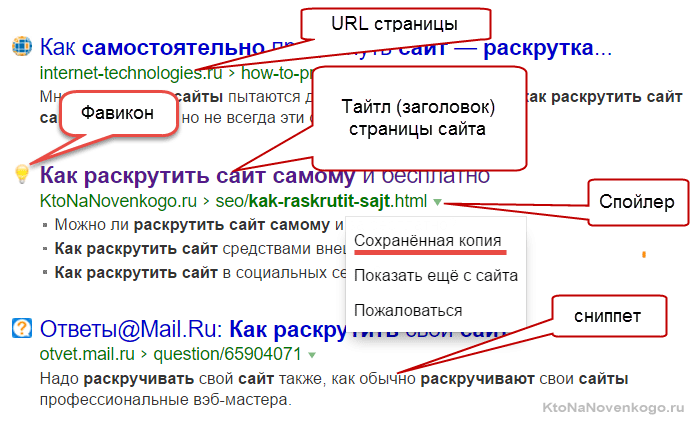

Але тут спочатку потрібно розібратися, а що таке фрагментом, для чого він потрібен і чому його вміст так важливо для оптимізатора? Результати пошуку розташовується відразу під посиланням на знайдений документ (текст якої береться з метатега TITLE, про важливість якого я тут вже писав):

Як фрагменту використовуються зазвичай шматки тексту цього документа. Ідеальний варіант покликаний надати користувачеві можливість скласти думку про вміст сторінки, не переходячи на неї (але це, якщо він вийшов вдалим, а це не завжди так).

Сниппет формується автоматично і які саме фрагменти тексту будуть використовуватися в ньому вирішує алгоритм (що це?), і, що важливо, для різних запитів у однієї і тієї ж вебсторінки будуть різні фрагменти.

Але є ймовірність, що саме вміст тега Description іноді може бути використане (особливо в Google) як фрагменту. Звичайно ж, це ще буде залежати і від того пошукового запиту, у видачі якого він показується.

Але вміст тега Description може виводитися, наприклад, при збігу ключових слів запиту і слів, вжитих вами в дескрипшине або у разі, коли алгоритм сам ще не знайшов на вашому сайті фрагменти тексту для усіх запитів, по яким ваша сторінка потрапляє у видачу Яндекса або Гугла.

Тому не лінуйтеся і заповнюємо вміст тега Description для кожної статті. В WordPress це можна зробити, якщо ви використовуєте описаний тут плагін All in One SEO Pack (а його використовувати я вам настійно рекомендую).

Якщо ви фанат Джумлы, то можете скористатися цим матеріалом — Настройка мета-даних в Joomla (мета-тегів DESCRIPTION, KEYWORDS, TITLE і ROBOTS).

Але фрагментом можна отримати із зворотного індексу, т. к. там зберігається інформація тільки про використані на сторінці словах і їх місце в тексті. Ось саме для створення фрагментів одного і того ж документа в різних пошукових ведучих (за різними запитами) наші улюблені Яндекс і Гугл, крім зворотного індексу (потрібного безпосередньо для ведення пошуку — про нього читайте нижче), зберігають ще і прямий індекс, тобто копію веб-сторінки.

Зберігаючи копію документа у себе в базі їм потім досить зручно нарізати з них потрібні фрагменти, не звертаючись при цьому до оригіналу.

Т. о. виходить, що пошукачі зберігають у своїй базі і прямий, і зворотний індекс веб-сторінки. До речі, на формування фрагментів можна опосередковано впливати, оптимізуючи текст веб-сторінки таким чином, щоб алгоритм вибирав як оного саме той фрагмент тексту, який ви задумали. Але про це поговоримо вже в іншій статті рубрики Просування сайтів (SEO і SMO)

Як працюють пошукові системи в загальних рисах

Суть оптимізації полягає в тому, щоб «допомогти» алгоритмів пошуковиків підняти сторінки тих сайтів, які ви просуваєте, на максимально високу позицію у видачі по тим чи іншим запитам.

Слово «допомогти» в попередньому реченні я взяв у лапки, оскільки своїми оптимизаторскими дії ми не зовсім допомагаємо, а часто і зовсім заважаємо алгоритмом зробити повністю релевантну запитом про видачу (про загадкових словах релевантність, ранжування та інших можна почитати тут).

Але це хліб оптимізаторів, і поки алгоритми пошуку не стануть досконалими, будуть існувати можливості за рахунок внутрішньої і зовнішньої оптимізації поліпшити їх позиції у видачі Яндекса і Google.

Але перш, ніж переходити до вивчення методів оптимізації, потрібно буде хоча б поверхово розібратися в принципах роботи пошукачів, щоб всі подальші дії робити усвідомлено і розуміючи навіщо це потрібно і як на це відреагують ті, кого ми намагаємося трохи обдурити.

Ясна річ, що зрозуміти всю логіку їх роботи від і до в нас не вийде, бо многая інформація не підлягає розголошенню, але нам, на перших порах, буде досить і розуміння основних принципів. Отже, приступимо.

Як же все-таки працюють пошукові системи? Як не дивно, але логіка роботи у них всіх, в принципі однакова і полягає в наступному: збирається інформація про всі вебстраницах в мережі, до яких вони можуть дотягнутися, після чого ці дані хитрим чином обробляються для того, щоб ними зручно було б вести пошук. Ось, власне, і все, на цьому статтю можна вважати завершеною, але все ж додамо трохи конкретики.

По-перше, уточнимо, що документом називають те, що ми зазвичай називаємо сторінкою сайту. При цьому він повинен мати унікальну адресу (URL, про який ми з вами розмовляли тут) і, що примітно, хеш-посилання не будуть призводити до появи нового документа (про те, що таке хеш-посилання читайте тут).

По-друге, варто зупинитися на алгоритмах (способи) пошуку інформації в базі зібраної документів.

Алгоритми прямих і зворотних індексів

Очевидно, що метод простого перебору всіх сторінок, що зберігаються в базі даних, не буде оптимальним. Цей метод називається алгоритмом прямого пошуку і при тому, що цей метод дозволяє напевно знайти потрібну інформацію не пропустили нічого важливого, він абсолютно не підходить для роботи з великими обсягами даних, бо пошук буде займати занадто багато часу.

Тому для ефективної роботи з великими обсягами даних було розроблено алгоритм зворотних (інвертованих) індексів. І, що примітно, саме він використовується всіма великими пошуковими системами у світі. Тому на ній ми зупинимося докладніше і розглянемо принципи його роботи.

При використанні алгоритму зворотних індексів відбувається перетворення документів в текстові файли, які містять список усіх наявних у них слів.

Слова в таких списках (індекс-файлах) розташовуються в алфавітному порядку і поряд з кожним з них вказані у вигляді координат ті місця в веб, де це слово зустрічається. Крім позиції в документі для кожного слова наводяться ще й інші параметри, які визначають його значення.

Якщо ви згадаєте, то в багатьох книгах (в основному технічних або наукових) на останніх сторінках наводиться список слів, що використовуються в даній книзі, з зазначенням номерів сторінок, на яких вони зустрічаються. Звичайно ж, цей перелік не включає взагалі всіх слів, що використовуються в книзі, але тим не менш може служити прикладом побудови індекс-файлу за допомогою інвертованих індексів.

Звертаю вашу увагу, що пошукові системи шукають інформацію не в інтернеті, а в зворотних індексах оброблених ними вебсторінок мережі. Хоча і прямі індекси (оригінальний текст) вони теж зберігають, т. к. він надалі знадобиться для складання фрагмента, але про це ми вже говорили на початку цієї публікації.

Алгоритм зворотних індексів використовується усіма системами, оскільки він дозволяє прискорити процес, але при цьому будуть неминучі втрати інформації за рахунок спотворень внесених перетворенням документа в індекс-файл. Для зручності зберігання файли зворотних індексів зазвичай хитрим способом стискаються.

Математична модель використовується для ранжирування

Для того, щоб здійснювати пошук за зворотним індексам, використовується математична модель, яка дозволяє спростити процес виявлення потрібних вебсторінок (по введеному користувачем запитом) і процес визначення релевантності усіх знайдених документів цього запиту. Чим більше він відповідає даним запитом (чим він релевантні), тим вище він повинен стояти в пошуковій видачі.

Отже, основне завдання, що виконується математичною моделлю — це пошук сторінок у своїй базі зворотних індексів відповідних даним запитом і їх подальша сортування в порядку убування релевантності даним запитом.

Використання простої логічної моделі, коли документ буде знайденим, якщо у ньому зустрічається шукана фраза, нам не підійде, в силу величезної кількості таких вебсторінок, які видаються на розгляд користувачеві.

Пошукова система повинна не тільки надати список всіх веб-сторінок, на яких зустрічаються слова запиту. Вона повинна надати цей список в такій формі, коли на самому початку будуть знаходитися найбільш відповідних запиту користувача документів (здійснити сортування по релевантності). Це завдання не тривіальна і за замовчуванням не може бути виконана ідеально.

До речі, неідеальної будь-математичної моделі і користуються оптимізатори, впливаючи тими чи іншими способами на ранжирування документів на видачу (в користь просувається ними сайту, природно). Матмодель, що використовується всіма пошуковими системами, відноситься до класу векторних. У ній використовується таке поняття, як вага документа по відношенню до заданим користувачем запитом.

У базовій векторної моделі вага документу по заданому запиту вираховується виходячи з двох основних параметрів: частоти, з якою в ньому зустрічається дане слово (TF — term frequency) і тим, наскільки рідко це слово зустрічається у всіх інших сторінках колекції (IDF — inverse document frequency).

Під колекцією мається на увазі вся сукупність сторінок, відомих пошуковій системі. Помноживши ці два параметри один на одного, ми одержимо вага документу по заданому запиту.

Природно, що різні пошуковики, крім параметрів TF і IDF, використовують безліч різних коефіцієнтів для розрахунку ваги, але суть залишається незмінною: вага сторінки буде тим більше, чим частіше слово з пошукового запиту зустрічається в ній (до певних меж, після яких документ може бути визнаний спамом) і чим рідше зустрічається це слово у всіх інших документах проіндексованих цією системою.

Оцінка якості роботи формули асесорами

Таким чином виходить, що формування видач за тим чи іншим запитам здійснюється повністю за формулою без участі людини. Але ніяка формула не буде працювати ідеально, особливо на перших порах, тому потрібно здійснювати контроль за роботою математичної моделі.

Для цих цілей використовуються спеціально навчені люди — асесори, які переглядають видачу (конкретно тієї пошукової системи, яка їх найняла) по різних запитах і оцінюють якість роботи поточної формули.

Всі внесені ними зауваження враховуються людьми, які відповідають за налаштування матмодели. В її формулу вносяться зміни або доповнення, в результаті чого якість роботи пошукача підвищується. Виходить, що асесори виконують роль такої своєрідної зворотного зв’язку між розробниками алгоритму і його користувачами, яка необхідна для поліпшення якості.

Основними критеріями в оцінці якості роботи формули є:

Як Яндекс і Гугл збирають свою колекцію

Незважаючи на уявну простоту індексації веб-сторінок тут є маса нюансів, які потрібно знати, а надалі і використовувати при оптимізації (SEO) або ж замовних сайтів. Індексація мережі (збір колекції) здійснюється спеціально призначеною для цього програмою, званої пошуковим роботом (ботом).

Робот отримує початковий список адрес, які він повинен буде відвідати, скопіювати вміст цих сторінок і віддати це вміст на подальшу переробку алгоритмом (він перетворює їх у зворотні індекси).

Робот може ходити не тільки по заздалегідь даного йому списком, але і переходити за посиланнями з цих сторінок і індексувати знаходяться за цим посиланням документи. Т. о. робот веде себе точно так само, як і звичайний користувач, що переходить за посиланнями.

Тож виходить, що за допомогою робота можна проіндексувати все те, що доступно зазвичай користувачеві, що використовує браузер для серфінгу (пошуковики індексують документи прямої видимості, які може побачити будь-який користувач інтернету).

Є ряд особливостей, пов’язаних з індексацією документів в мережі (нагадаю, що ми вже обговорювали тут заборона індексації через robots txt).

Першою особливістю можна вважати те, що крім зворотного індексу, який створюється з оригінального документа скачаного з мережі, пошукова система зберігає ще і його копію, інакше кажучи, пошуковики зберігають ще і прямий індекс. Навіщо це потрібно? Я вже згадував трохи раніше, що це потрібно для складання різних фрагментів в залежності від введеного запиту.

Скільки сторінок сайту Яндекс показує у видачі та індексує

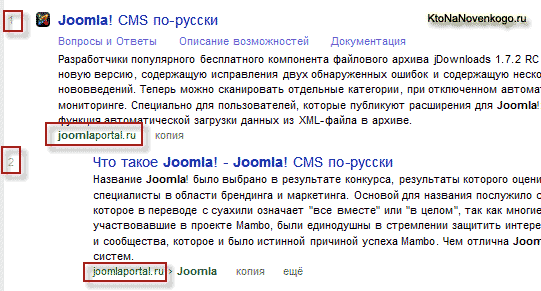

Звертаю вашу увагу на таку особливість роботи Яндекса, як наявність у видачі по заданому запиту всього лише одного документа з кожного сайту. Такого, щоб у видачі були присутні на різних позиціях дві сторінки з одного і того ж ресурсу, бути не могло до недавнього часу.

Це було одне з основних правил Яндекса. Якщо навіть на одному сайті знайдеться сотня релевантних заданому запиту сторінок, у видачі буде присутній тільки один (найбільш релевантний).

Яндекс зацікавлений у тому, щоб користувач отримував різноманітну інформацію, а не проглядав кілька сторінок пошукової видачі зі сторінками одного і того ж сайту, який цього користувачеві виявився не цікавий по тим або іншим причинам.

Однак, поспішаю виправитися, бо коли дописав цю статтю дізнався, що виявляється Яндекс став допускати відображення у видачі другого документа з того ж ресурсу, у якості винятки, якщо ця сторінка виявиться «дуже хороша і доречна» (інакше кажучи сильно релевантна запиту).

Що примітно, ці додаткові результати з того ж самого сайту теж нумеруються, отже, з-за цього з топа випадуть деякі ресурси, що займають нижчі позиції. Ось приклад нової видачі Яндекса:

Пошуковики прагнуть рівномірно індексувати всі вебсайти, але найчастіше це буває не просто з-за абсолютно різної кількості сторінок на них (у кого-то десять, а у кого-то десять мільйонів). Як бути в цьому випадку?

Яндекс виходить з цього положення обмеженням кількості документів, яку він зможе загнати в індекс з одного сайту.

Для проектів з доменним ім’ям другого рівня, наприклад, максимальна кількість сторінок, яке може бути проіндексовано дзеркалом рунета, знаходиться в діапазоні від ста до ста п’ятдесяти тисяч (конкретне число залежить від відношення до даного проекту).

Для ресурсів з доменним ім’ям третього рівня — від десяти до тридцяти тисяч сторінок документів).

Якщо у вас сайт з доменом другого рівня (подробиці про домени шукайте тут), а вам потрібно буде загнати в індекс, наприклад, мільйон вебсторінок, то єдиним виходом з цієї ситуації буде створення безлічі піддоменів (Створення піддоменів (субдоменів)).

Піддомени домену другого рівня можуть виглядати так: JOOMLA.. Кількість піддоменів для другого рівня, яке може проіндексувати Яндекс, становить десь трохи більше 200 (іноді начебто й до тисячі), тому таким нехитрим способом ви зможете загнати в індекс дзеркала рунета кілька мільйонів вебсторінок.

Як Яндекс відноситься до сайтів в російськомовних доменних зонах

У зв’язку з тим, що Яндекс до недавнього часу шукав тільки за російськомовній частині інтернету, то і індексував він в основному російськомовні проекти.

Тому, якщо ви створюєте сайт не в доменних зонах, які він за замовчуванням відносить до російськомовних (RU, SU UA), то чекати швидкої індексації не варто, оскільки він, швидше за все, його знайде не раніше ніж через місяць. Але вже подальша індексація буде відбуватися з тією ж частотою, що і в російськомовних доменних зонах.

Тобто доменна зона впливає лише на час, який пройде до початку індексації, але не впливатиме у подальшому на її частоту. До речі, від чого залежить ця частота?

Логіка роботи пошукових систем по переіндексації сторінок зводиться приблизно до наступного:

Т. о. з часом частота приходу робота на цю сторінку зрівняється з частотою оновлення чи буде порівнянна з нею. Причому, час повторного заходження робота може вимірюватися для різних сайтів як в хвилинах, так і в роках.

Такі ось вони розумні пошукові системи, складаючи індивідуальний графік відвідування для різних сторінок різних ресурсів. Можна, правда, примусити пошуковики переіндексувати сторінку за нашим бажанням, навіть якщо на ній нічого не змінилося, але про це в іншій статті.

Продовжимо вивчати принципи роботи пошуку в наступній статті, де ми розглянемо проблеми, з якими стикаються пошуковики, розглянемо нюанси роботи з морфологією російської мови і дізнаємося деякі подробиці за запитами користувачів — читайте тут. Ну, і багато іншого, звичайно ж, так чи інакше допомагає розкрутити сайт.

Удачі вам! До зустрічей на сторінках блогу