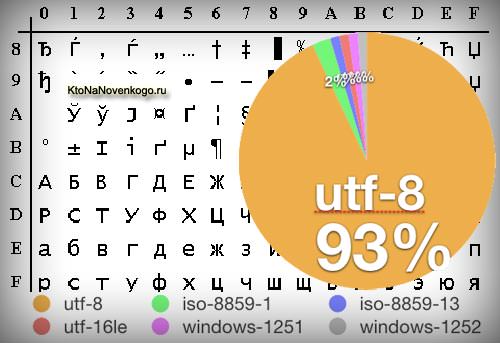

Здрастуйте, шановні читачі блогу . Сьогодні ми поговоримо з вами про те, звідки беруться кракозябры на сайті і в програмах, які кодування тексту існують і які з них слід використовувати. Докладно розглянемо історію їх розвитку, починаючи від базової ASCII, а також її розширених версій CP866, KOI8-R, Windows 1251 і закінчуючи сучасними кодуваннями консорціуму Юнікод UTF 16 і 8.

Кому-то ці відомості можуть здатися зайвими, але знали б ви, скільки мені приходить питань саме стосовно вылезших кракозябров (не читається набору символів). Тепер у мене буде можливість посилати всіх до тексту цієї статті та самостійно відшукувати свої косяки. Ну що ж, приготуйтеся вбирати інформацію і постарайтеся стежити за ходом розповіді.

ASCII — базова кодування тексту для латиниці

Розвиток кодувань текстів відбувалося одночасно з формуванням галузі IT, і вони за цей час встигли зазнати досить багато змін. Історично все починалося з досить-таки не милозвучно в російській вимові EBCDIC, яка дозволяла кодувати літери латинського алфавіту, арабські цифри і знаки пунктуації з керуючими символами.

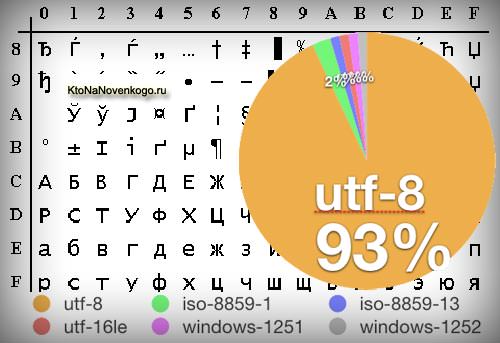

Але все ж відправною точкою для розвитку сучасних кодувань текстів варто вважати знамениту ASCII (American Standard Code for Information Interchange, яка по-російськи зазвичай вимовляється як «аскі»). Вона описує перші 128 символів з найбільш часто використовуваних англомовними користувачами — латинські букви, арабські цифри і знаки пунктуації.

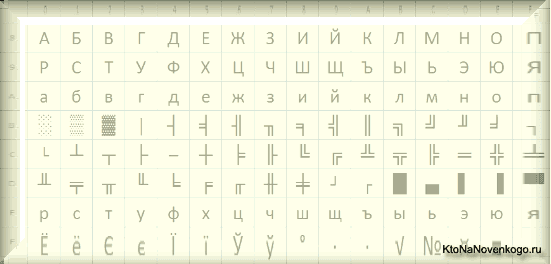

Ще в ці 128 знаків, описаних в ASCII, потрапляли деякі службові символи навроде дужок, решіток, зірочок і т. п. Власне, ви самі можете побачити їх:

Саме ці 128 символів початкового варіант ASCII стали стандартом, і в будь-який інший кодуванні ви їх обов’язково зустрінете і стоятимуть вони саме в такому порядку.

Але справа в тому, що за допомогою одного байта інформації можна закодувати не 128, а цілих 256 різних значень (двійка в ступені вісім дорівнює 256), тому слідом за базовою версією Аски з’явився цілий ряд розширених кодування ASCII, в яких можна було крім 128 основних символів закодувати ще й символи національної кодування (наприклад, російською).

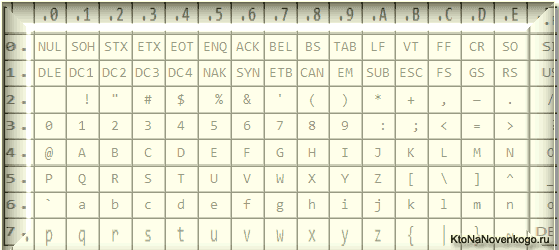

Тут, напевно, варто ще трохи сказати про системи числення, які використовуються при описі. По-перше, як ви всі знаєте, комп’ютер працює тільки з числами в двійковій системі, а саме з нулями та одиницями («булева алгебра», якщо хтось проходив в інституті або в школі). Один байт складається з восьми біт, кожний з яких представляє з себе двійку в ступені, починаючи з нульової, і до двійки в сьомий:

Не важко зрозуміти, що всіх можливих комбінацій нулів і одиниць у такої конструкції може бути лише 256. Переводити числа з двійкової системи в десяткову досить просто. Треба просто скласти всі ступені двійки, над якими стоять одиниці.

У нашому прикладі це виходить 1 (2 в ступені нуль) плюс 8 (два в ступені 3), плюс 32 (двійка в п’ятого ступеня), плюс 64 (шостий), плюс 128 (сьомий). Загальна отримує 233 в десятковій системі числення. Як бачите, все дуже просто.

Але якщо ви придивитеся до таблиці символів ASCII, то побачите, що вони представлені в шістнадцятковому кодуванні. Наприклад, «зірочка» відповідає в Аски шестнадцатеричному числа 2A. Напевно, вам відомо, що в шістнадцятковій системі числення використовуються крім арабських цифр ще й латинські літери від A (означає десять) до F (означає п’ятнадцять).

Ну так от, для переведення двійкового числа у шістнадцяткове вдаються до наступного простому і наочному способом. Кожен байт інформації розбивають на дві частини по чотири біта, як показано на наведеному вище скріншоті. Т. о. в кожній половинці байта можна закодувати двійковим кодом тільки шістнадцять значень (два в четвертого ступеня), що можна легко представити шістнадцятковим числом.

Причому, у лівій половині байта вважати мірою потрібно буде знову починаючи з нульової, а не так, як показано на скріншоті. В результаті, шляхом нехитрих обчислень, ми отримаємо, що на скріншоті закодовано число E9. Сподіваюся, що хід моїх міркувань і розгадка цього ребуса вам виявилися зрозумілі. Ну, а тепер продовжимо, власне, говорити про кодування тексту.

Розширені версії Аскі — кодування CP866 і KOI8-R з псевдографикой

Отже, ми з вами почали говорити про ASCII, яка була як би відправною точкою для розвитку всіх сучасних кодувань (Windows 1251, юнікод UTF 8).

Спочатку в неї було закладено лише 128 символів латинського алфавіту, арабських цифр і ще чогось там, але в розширеній версії з’явилася можливість використовувати всі 256 значень, які можна закодувати в одному байті інформації. Тобто з’явилася можливість додати у Аски символи букв своєї мови.

Тут потрібно буде ще раз відволіктися, щоб пояснити — навіщо взагалі потрібні кодування текстів і чому це так важливо. Символи на екрані вашого комп’ютера формуються на основі двох речей — наборів векторних форм (подань) всіляких знаків (вони знаходяться у файлах зі шрифтами, які встановлені на вашому комп’ютері) і коду, який дозволяє висмикнути з цього набору векторних форм (файлу шрифту) саме той символ, який потрібно буде вставити в потрібне місце.

Зрозуміло, що за самі векторні форми відповідають шрифти, а ось за кодування відповідає операційна система і які використовуються в неї програми. Тобто будь-який текст на вашому комп’ютері буде представляти собою набір байтів, в кожному з яких закодовано один єдиний символ цього самого тексту.

Програма, яка відображає цей текст на екрані (текстовий редактор, браузер тощо), при розборі коду зчитує кодування чергового знака і шукає відповідну йому векторну форму в потрібному файлі шрифту, який підключений для відображення даного текстового документа. Все просто і банально.

Значить, щоб закодувати будь-який потрібний нам символ (наприклад, з національного алфавіту), повинно бути виконано дві умови — векторна форма цього знака повинна бути у використовуваному шрифті цей символ можна було б закодувати в розширених кодуваннях ASCII в один байт. Тому таких варіантів існує ціла купа. Тільки лише для кодування символів російської мови існує кілька різновидів розширеної Аски.

Наприклад, спочатку з’явилася CP866, в якій була можливість використовувати символи російського алфавіту і вона була розширеною версією ASCII.

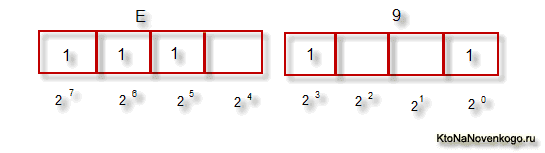

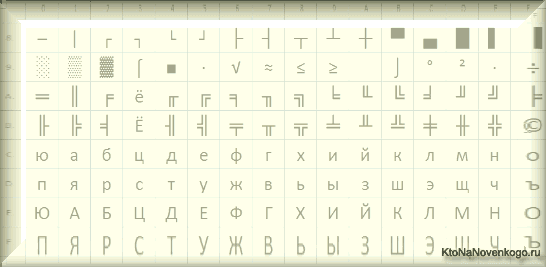

Тобто її верхня частина повністю співпадала з базовою версією Аски (128 символів латиниці, цифр і ще всякої лабуди), яка представлена на наведеному трохи вище скріншоті, а ось уже нижня частина таблиці з кодуванням CP866 мала зазначений на скріншоті трохи нижче вигляд і дозволяла закодувати ще 128 знаків (російські літери і всяка там псевдографіка):

Бачите, у правому стовпці починаються з цифри 8, т. к. числа від 0 до 7 відносяться до базової частини ASCII (див. перший скріншот). Т. о. російська буква «М» в CP866 буде мати код 9С (вона знаходиться на перетині відповідних рядка 9 і стовпця з цифрою З в шістнадцятковій системі числення), який можна записати в одному байті інформації, і при наявності відповідного шрифту з російськими символами ця буква без проблем відображається в тексті.

Звідки взялася така кількість псевдографіки в CP866? Тут вся справа в тому, що ця кодування для російського тексту розроблялася ще в ті волохаті року, коли не було такого поширення графічних операційних систем як зараз. А в Досі, і подібних їй текстових операционках, псевдографіка дозволяла хоч якось урізноманітнити оформлення текстів і тому нею рясніє CP866 і всі інші її ровесниці з розряду розширених версій Аски.

CP866 поширювала компанія IBM, але крім цього для символів російської мови були розроблені ще ряд кодувань, наприклад, до цього ж типу (розширених ASCII) можна віднести KOI8-R:

Принцип її роботи залишився той же самий, що і в описаної трохи раніше CP866 — кожен символ тексту кодується одним єдиним байтом. На скріншоті показано друга половина таблиці KOI8-R, т. к. перша половина повністю відповідає базовій Аски, яка показана на першому скріншоті в цій статті.

Серед особливостей кодування KOI8-R можна відзначити те, що російські літери в її таблиці йдуть не в алфавітному порядку, як це, наприклад, зробили в CP866.

Якщо подивитеся на самий перший скріншот (базової частини, яка входить у всі розширені кодування), то помітите, що в KOI8-R російські букви розташовані в тих же осередках таблиці, що і співзвучні їм літери латинського алфавіту з першої частини таблиці. Це було зроблено для зручності переходу з російських символів на латинські шляхом відкидання всього одного біта (два в сьомий ступеня або 128).

Windows 1251 — сучасна версія ASCII і чому вилазять кракозябры

Подальший розвиток кодувань тексту було пов’язано з тим, що набирали популярність графічні операційні системи та необхідність використання псевдографіки в них з часом зникла. В результаті виникла ціла група, яка по своїй суті, як і раніше, були розширеними версіями Аски (один символ тексту кодується одним байтом інформації), але вже без використання символів псевдографіки.

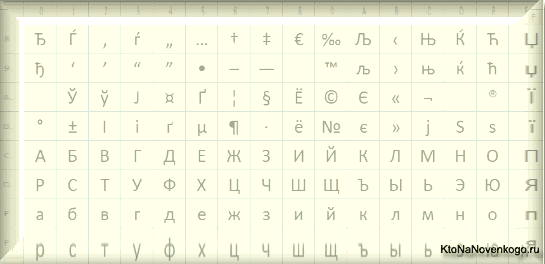

Вони ставилися до так званих кодувань ANSI, які були розроблені американським інститутом стандартизації. У просторіччі ще використовувалося назву кирилиця для варіанту з підтримкою російської мови. Прикладом такої може служити Windows 1251.

Вона вигідно відрізнялася від використовуваних раніше CP866 і KOI8-R тим, що місце символів псевдографіки в ній зайняли відсутні символи російської типографіки (окрім знака наголосу), а також символи, використовувані в близьких до російської слов’янських мовах (українській, білоруській і т. д.):

З-за такої великої кількості кодувань російської мови, у виробників шрифтів і виробників програмного забезпечення постійно виникала головний біль, а у нас з вас, шановні читачі, часто вилазили ті самі горезвісні кракозябры, коли відбувалася плутанина з використовуваної в тексті версією.

Дуже часто вони вилазили надсилання й отримання повідомлень електронною поштою, що спричинило за собою створення дуже складних перекодировочных таблиць, які, власне, вирішити цю проблему в корені не змогли, і часто користувачі для листування використовували трансліт латинських букв, щоб уникнути горезвісних кракозябров при використанні російських кодувань подібних CP866, KOI8-R або Windows-1251.

По суті, кракозябры, вилазящіе замість російського тексту, були результатом некоректного використання кодування даного мови, яка не відповідала тій, в якій було закодовано текстове повідомлення спочатку.

Припустимо, якщо символи, які закодовані з допомогою CP866, спробувати відобразити, використовуючи кодову таблицю Windows 1251, то ці самі кракозябры (безглуздий набір знаків) і вилізуть, повністю замінивши собою текст повідомлення.

Аналогічна ситуація дуже часто виникає при створенні сайтів на WordPress і Joomla, форумів або блогів, коли текст з російськими символами помилково зберігається не в тій кодуванні, яка використовується на сайті за замовчуванням, або ж не в тому текстовому редакторі, який додає в код відсебеньки не видиму неозброєним оком.

Зрештою така ситуація з великою кількістю кодувань і постійно вилазять кракозябрами багатьом набридла, з’явилися передумови до створення нової універсальної варіації, яка б замінила собою всі існуючі і вирішила б, нарешті, на корені проблему з появою не читаних текстів. Крім цього існувала проблема мов подібних китайському, де символів мови було набагато більше, ніж 256.

Юнікод (Unicode) — універсальні кодування UTF 8, 16 і 32

Ці тисячі знаків мовної групи південно-східної Азії ніяк неможливо було описати в одному байті інформації, який виділявся для кодування символів в розширених версіях ASCII. В результаті був створений консорціум під назвою Юнікод (Unicode — Unicode Consortium) при співпраці багатьох лідерів IT-індустрії (ті, хто виробляє софт, хто кодує залізо, хто створює шрифти), які були зацікавлені у появі універсальної кодування тексту.

Першою варіацією, що вийшла під егідою консорціуму Юнікод, була UTF 32. Цифра в назві кодування означає кількість біт, що використовується для кодування одного символу. 32 біта складають 4 байти інформації, які знадобляться для кодування одного символу нової універсальної кодуванні UTF.

В результаті чого, один і той же файл з текстом, закодований у розширеній версії ASCII і в UTF-32, в останньому випадку буде мати розмір (важити) в чотири рази більше. Це погано, але зате тепер у нас з’явилася можливість закодувати за допомогою ЮТФ число знаків, рівна двом тридцять другого ступеня (мільярди символів, які покриють будь реально необхідне значення з колосальним запасом).

Але багатьом країнам з мовами європейської групи така величезна кількість знаків використовувати в кодуванні зовсім і не було необхідності, однак при залученні UTF-32 вони ні за що ні про що отримували чотириразове збільшення ваги текстових документів, а в результаті і збільшення обсягу інтернет-трафіку і обсягу збережених даних. Це багато, і таке марнотратство собі ніхто не міг дозволити.

В результаті розвитку Юнікоду з’явилася UTF-16, яка вийшла настільки вдалою, що була прийнята за замовчуванням як базове простір для всіх символів, які у нас використовуються. Вона використовує два байти для кодування одного символу. Давайте подивимося, як це виглядає.

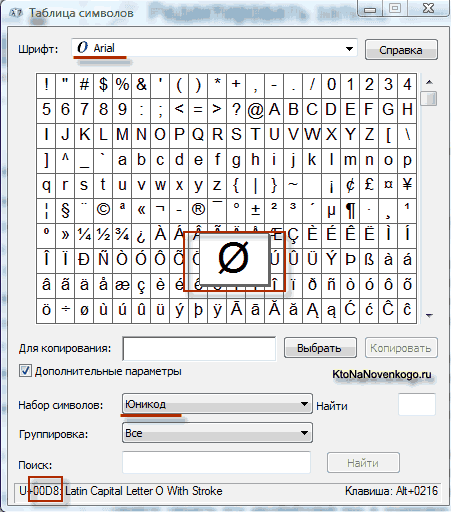

В операційній системі Windows, ви можете пройти по шляху «Пуск» — «Програми» — «Стандартні» — «Службові» — «Таблиця символів». В результаті відкриється таблиця з векторними формами всіх встановлених в системі шрифтів. Якщо ви виберете «Додаткові параметри» набір символів Юнікод, то зможете побачити для кожного шрифту окремо весь асортимент вхідних у нього символів.

До речі, клацнувши по будь-якому з них, ви зможете побачити його двобайтовий код у форматі UTF-16, що складається з чотирьох шістнадцяткових цифр:

Скільки символів можна закодувати в UTF-16 з допомогою 16 біт? 65 536 (два в ступені шістнадцять), і саме це число було прийнято за базовий простір в Юнікод. Крім цього існують способи закодувати за допомогою неї і близько двох мільйонів знаків, але обмежилися розширеним простором в мільйон символів тексту.

Але навіть ця вдала версія кодування Юнікоду не принесла особливого задоволення тим, хто писав, припустимо, програми англійською мовою, бо у них, після переходу від розширеної версії ASCII до UTF-16, вага документів збільшувався в два рази (один байт на один символ у Аски і два байти на той самий символ у ЮТФ-16).

Ось саме для задоволення всіх і вся в консорціум Unicode було вирішено придумати кодування змінної довжини. Її назвали UTF-8. Незважаючи на вісімку в назві, вона дійсно має змінну довжину, тобто кожен символ тексту може бути закодований послідовність довжиною від одного до шести байт.

На практиці ж у UTF-8 використовується тільки діапазон від одного до чотирьох байт, тому що за чотирма байтами коду нічого вже навіть теоретично не можливо уявити. Всі латинські знаки в ній закодовані в один байт, так само як і в старій добрій ASCII.

Що примітно, у випадку кодування тільки латиниці, навіть ті програми, які не розуміють Юнікод, все одно прочитають те, що закодовано в ЮТФ-8. Тобто базова частина Аски просто перейшла в це дітище консорціуму Unicode.

Кириличні ж знаки в UTF-8 кодуються в два байти, а, наприклад, грузинські — в три байти. Консорціум Unicode після створення UTF 16 і 8 вирішив основну проблему — тепер у нас в шрифтах існує єдине кодове простір. І тепер їх виробникам залишається тільки виходячи зі своїх сил і можливостей заповнювати його векторними формами символів тексту. Зараз в набори навіть смайликів емодзі додають.

У наведеній трохи вище «Таблиця символів» видно, що різні шрифти підтримують різна кількість знаків. Деякі насичені символами Unicode шрифти можуть важити дуже пристойно. Але зате тепер вони відрізняються не тим, що вони створені для різних кодувань, а тим, що виробник шрифту заповнив або не заповнив єдину кодову простір тими чи іншими векторними формами до кінця.

Кракозябры замість російських букв — як виправити

Давайте тепер подивимося, як з’являються замість тексту кракозябры або, іншими словами, як вибирається правильна кодування для російського тексту. Власне, вона задається у тій програмі, в якій ви створюєте або редагуєте цей самий текст, або ж код з використанням текстових фрагментів.

Для редагування і створення текстових файлів особисто я використовую дуже хороший, на мій погляд, Html і PHP редактор Notepad++. Втім, він може підсвічувати синтаксис ще доброї сотні мов програмування та розмітки, а також має можливість розширення за допомогою плагінів. Читайте детальний огляд цієї чудової програми за наведеним посиланням.

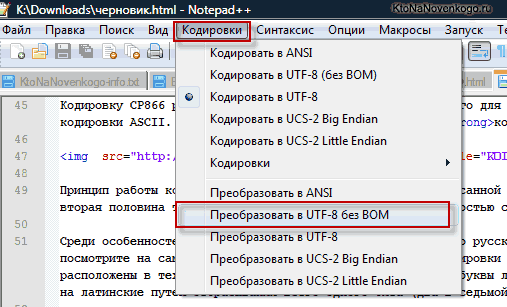

У верхньому меню Notepad++ є пункт «Кодування», де у вас буде можливість перетворити вже наявний варіант того, який використовується на вашому сайті за замовчуванням:

Сайт на Joomla 1.5 і вище, а також у разі блогу на WordPress слід під уникнення появи кракозябров вибирати варіант UTF 8 без BOM. А що таке приставка BOM?

Справа в тому, що коли розробляли кодування ЮТФ-16, навіщось вирішили прикрутити до неї таку річ, як можливість записувати код символу, як у прямій послідовності (наприклад, 0A15), так і в зворотному (150A). А для того, щоб програми розуміли, в якій саме послідовності читати коди, і був придуманий BOM (Byte Order Mark або, іншими словами, сигнатура), яка виражалася в додаванні трьох додаткових байтів в самий початок документів.

В кодуванні UTF-8 ніяких BOM передбачено в консорціум Unicode не було і тому додавання сигнатури (цих самих горезвісних додаткових трьох байтів в початок документа) деякими програмами просто-напросто заважає читати код. Тому ми завжди при збереженні файлів у ЮТФ повинні вибирати варіант без BOM (без підпису). Таким чином, ви заздалегідь убезпечите себе від вилізання кракозябров.

Що примітно, деякі програми Windows не вміють цього робити (не вміють зберігати текст у ЮТФ-8 без BOM), наприклад, все той же горезвісний Блокнот Windows. Він зберігає документ у UTF-8, але все одно додає в його початок сигнатуру (три додаткових байта). Причому ці байти будуть завжди одні і ті ж — читати код у прямій послідовності. Але на серверах з-за цієї дрібниці може виникнути проблема — вилізуть кракозябры.

Тому ні в якому разі не користуйтеся звичайним блокнотом Windows для редагування документів вашого сайту, якщо не хочете появи кракозябров. Кращим і найбільш простим варіантом я вважаю вже згаданий редактор Notepad++, який практично не має недоліків і складається з одних достоїнств.

В Notepad ++ при виборі кодування у вас буде можливість перетворити текст в кодування UCS-2, яка за своєю суттю дуже близька до стандарту Юнікод. Також в Нотепаде можна закодувати текст в ANSI, тобто стосовно до російської мови це буде вже описана нами трохи вище Windows 1251. Звідки береться ця інформація?

Вона прописана в реєстрі операційної системи Windows — яку вибирати кодування у разі ANSI, яку обирати у разі OEM (для російської мови це буде CP866). Якщо ви встановите на своєму комп’ютері іншу мову за замовчуванням, то і ці кодування будуть замінені на аналогічні з розряду ANSI або OEM для того самого мови.

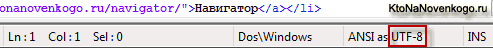

Після того, як ви в Notepad++ збережіть документ в потрібній вам кодуванні або ж відкрити документ з сайту для редагування, то в правому нижньому куті редактора зможете побачити її назву:

Щоб уникнути кракозябров, крім описаних вище дій, буде корисним прописати в його шапці вихідного коду всіх сторінок сайту інформацію про цю саму кодуванні, щоб на сервері або на локальному хості не виникло плутанини.

Взагалі, у всіх мовах розмітки крім Html використовується спеціальне оголошення xml, у якому вказується кодування тексту.

Перш, ніж почати розбирати код, браузер дізнається, яка версія використовується і як саме потрібно інтерпретувати коди символів цієї мови. Але що примітно, у разі, якщо ви зберігаєте документ у прийнятому за замовчуванням юнікод, то це оголошення xml можна буде опустити (кодування буде вважатися UTF-8, якщо немає BOM або ЮТФ-16, якщо BOM є).

У разі ж документа мови Html для вказівки кодування використовується елемент Meta, який прописується між відкриваючим і закриваючим тегом Head:

…

…

Ця запис досить сильно відрізняється від прийнятої в стандарті Html 4.01, але повністю відповідає новому внедряемому потихеньку стандарту Html 5, і вона буде стовідсотково правильно зрозуміла будь-якими використовуються на поточний момент браузерами.

По ідеї, елемент Meta із зазначення кодування Html документу буде ставити якомога вище в шапці документа, щоб на момент зустрічі в тексті першого знака не з базової ANSI (які правильно прочитаются завжди і в будь-якій варіації) браузер вже повинен мати інформацію про те, як інтерпретувати коди цих символів.

Удачі вам! До зустрічей на сторінках блогу